AMD и Untether соперничают с Nvidia в тестах MLPerf

Сравнительный тест MLPerf впервые включает результаты MI300X GPU, флагманского чипа от AMD. Претендент показал результаты, сопоставимые с Nvidia H100/H200, лидером на рынке современного аппаратного обеспечения. И хотя в общем Nvidia победила, но с небольшим отрывом. Стартап Untether также бросил вызов Nvidia, показав первые MLPerf-бенчмарки ускорителя SpeedAI, где он обошёл различные чипы Nvidia в ResNet-50, тесте энергоэффективности в рабочей нагрузке.

AMD MI300X

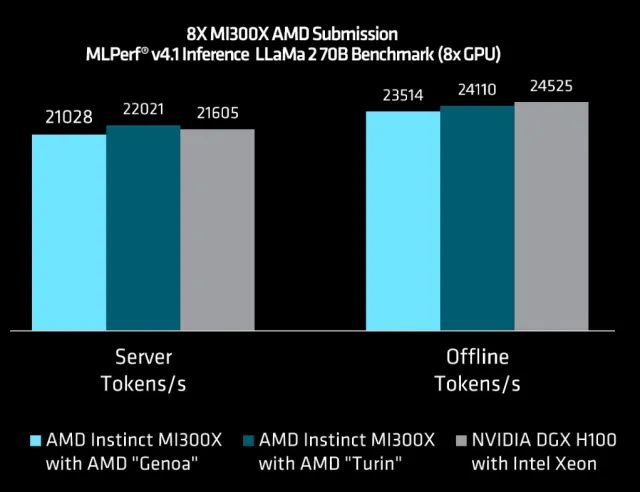

AMD представила первые результаты своего чипа MI300X, соперника Nvidia в области графических процессоров (GPU) для дата-центров, показав его производительность в одно- и восьмичиповых системах для модели Llama 2-70B. Один MI300X может выводить 2 520,27 токенов в секунду (т/с) в режиме сервера или 3 062,72 т/с в оффлайн-режиме, в то время как 8 чипов могут делать 21 028,20 т/с и 23 514,80 т/с соответственно. Цифры безусловно показывают линейную зависимость масштабируемости от размера системы. (Напомним, что оффлайн-сценарий позволяет пакетную обработку для максимизации пропускной способности, тогда как более сложный серверный сценарий симулирует запросы в реальном времени, соблюдая ограничения по задержке).

Такие результаты очень схожи (с разницей 3-4%) с результатами чипа H100-80Gb от Nvidia при той же рабочей нагрузке в 8-чиповых системах. При сравнении с H200-141Gb (фактически тем же H100, но с увеличенным объемом и скоростью памяти), AMD отстает на 30-40%.

Свой 12-чиповый графический процессор MI300X AMD позиционировала именно как соперника H100 от Nvidia, и он широко рассматривается как одно из наиболее перспективных коммерческих предложений, направленных на то, чтобы занять место «зелёной команды» на рынке. У MI300X больше ёмкость и пропускная способность HBM-памяти, чем у H100 и H200 от Nvidia (MI300X имеет 192 Гб с 5,2 Тб/с против 141 Гб с 4,8 Тб/с у H200), что должно быть заметно в результатах обработки больших языковых моделей (LLM).

AMD заявила, что 192 Гб более чем достаточно для размещения на одном чипе всей модели Llama 2-70B вместе с KV-кэшем (промежуточными результатами), во избежание излишнего потребления ресурсов сети, вызываемого распределением вычислений между несколькими GPU. Также у MI300X немного больше FLOPS, чем у H100/200. Паритет с H100 и отставание от H200 могут немного разочаровать фанатов AMD, но эти первоначальные результаты, несомненно, в дальнейшем улучшаться благодаря программной оптимизации.

Что касается программного обеспечения, AMD заявила о широком использовании своей библиотеки компонуемых ядер (CK) для того, чтобы написать ядра, особенно требовательные к производительности, например, ядро «предварительного внимания», ядро «внимание к постраничному декодированию модели FP8» и различные «слитые» ядра. Это также ускорит планировщик декодирования и улучшит механизм предварительной пакетной обработки.

Также AMD анонсировала центральные процессоры (CPU) следующего поколения EPYC Turin в сочетании с MI300X; прирост был весьма незначительным — 4,7% в серверном режиме или 2,5% в автономном режиме по сравнению с такой же системой на процессоре Genoa, но этого оказалось достаточно, чтобы система на базе Turin немного обогнала DGX-H100. Процессоров Turin пока нет в продаже.

Результаты AMD MI300X сопоставимы с показателями Nvidia H100-80GB. (Источник: AMD)

Blackwell от Nvidia

В этом раунде Nvidia представила Blackwell B200. Это первый GPU новой архитектуры Blackwell с удвоенной по сравнению с H100/200 скоростью вычислений. Это стало возможно благодаря кристаллу с уменьшенным в два раза размером фотошаблона, а также увеличению памяти до 180 Гб против 141 Гб у H200. Также это первый GPU от Nvidia с поддержкой модели FP4.

Одиночный B200 в серверном режиме может выдать 10 755,60 т/с для Llama 2-70B, что более чем в 4 раза быстрее, чем H100, или 11 264,40 т/с в оффлайн-режиме, в 3,7 раза быстрее, чем H100. Заметим, что Nvidia впервые выделила запрос к модели FP4, и в результате пользователи могут запрашивать её обработку сколь угодно агрессивно, получая очень точное соответствие запросу, составляющее в данном случае 99,9%. По сравнению с H200 (с большей и более быстрой памятью, чем H100, и выделенной обработкой модели FP8), отличие составило больше 2,5 раз для обоих сценариев. Nvidia не сообщила, реализовала ли она запрос к FP4 как отдельную рабочую нагрузку. Это изменение даст возможность программному «движку» использовать модель вычислений «со смешанной точностью» для наилучших результатов в процессе обучения и вывода.

Результаты B200 были представлены в «предварительной» категории. Это означает, что Nvidia ожидает, появления Blackwell на рынке через полгода или меньше. Из-за того, что обе компании выпускают свои продукты одновременно, текущее поколение от AMD, MI300X, похоже, вскоре столкнётся с B200 от Nvidia. На сегодня B200 примерно в 4 раза быстрее, чем MI300X для вывода модели Llama 2-70B.

Nvidia и её партнёры с гордостью демонстрируют результаты для новой SMoE Mixtral 8x7B. У этой рабочей нагрузки 46,7 млрд. общих параметров и 12,9 активных на токен (SMoE-модели назначают запросы одной из нескольких (из 8 в данном случае) меньших подмоделей, называемых «экспертами»). В тесте Mixtral H200 превзошел H100 той же мощности (700W); у H200 в 1,8 раза больше памяти с пропускной способностью выше в 1,4 раза, но это обеспечило около 11–12% прироста производительности.

Nvidia утверждает, что извлекает на 27% больше производительности из GPU Hopper по сравнению с последними результатами, и что большая часть этих возможностей внедряется в инструменты разработчиков.

H200 от Nvidia со 141 Гб памяти HBM превосходит MI300X со 192 Гб в таком же энергопакете. При увеличении мощности H200 до 1000 Вт разрыв становится ещё больше. (Источник: Nvidia)

speedAI240 от Untether

Стартап Untether продемонстрировал первые результаты бенчмарка MLPerf, представив оценки производительности и энергопотребления для своего ускорителя второго поколения speedAI240 в нескольких системах с разной конфигурацией. Это ускоритель на 2 пета-FLOPS с более чем 1400 ядрами RISC-V, разработанный для энергоэффективности ИИ-вывода.

6 слим-карт PCIe от Untether (форм-фактора 2U, с акселератором на 75W каждая) могут обрабатывать 309 752 инф/с модели ResNet-50 в режиме сервера или 334 462 инф/с в оффлайн-режиме. Это примерно половина производительности системы из 8 Nvidia H100-SXM-80GB, представленной Supermicro, хотя система от Supermicro в два раза больше (форм-фактор 4U), а её тепловыделение выше в 10 раз. В пересчёте на ускоритель, один speedAI240 от Untether — это примерно 65% от производительности H100 (в данной конфигурации). Напомним, что в своих ускорителях Untether использует память не HBM, а LPDDR5 ёмкостью до 64 ГБ памяти и с пропускной способностью 100 Гб/с.

Untether располагает также системами в превью-категории (т.е. пока не представленные на рынке), основанными на большей одночиповой PCIe-карте с удвоением до 150W доступной акселератору мощности. Эта система также немного повышает тактовую частоту. Это улучшает результаты на 35% в серверном режиме или на 26% в оффлайн-режиме на ускоритель для модели ResNet-50. Две карты вместе обеспечивают удвоение производительности, демонстрируя линейную масштабируемость.

Результаты Untether действительно блестящи в отношении энергоэффективности. В модели ResNet-50 6 слим-карт с ускорителями (75W каждая) могут выводить 314 запросов в секунду на ватт в режиме сервера против 96 для системы из 8 карт Nvidia H200-141GB. Это дает Untether примерно в 3 раза большую энергоэффективность по сравнению с оборудованием Nvidia текущего поколения.

В Untether заявили, что в следующем раунде протестируют карту на 4 ускорителя, а затем возьмутся за модель Bert и LLM c большими рабочими нагрузками.

Результаты Edge для Untether в сравнении с Nvidia L40S на ResNet-50. (Источник: Untether)

Trillium от Google

Google с пометкой «предварительно» показала результаты тестов ускорителя следующего поколения, TPUv6e «Trillium», который будет запущен в серию в этом году. Trillium может выводить модель StableDiffusion со скоростью 4,49 запросов в секунду в режиме сервера или 5,44 в оффлайн-режиме. Это примерно утроение производительности по сравнению с нынешним поколением, TPUv5e. Для сравнения, Nvidia GH200 (Grace Hopper 144 Гб) делает 2,02 запроса в секунду в режиме сервера и 2,30 в оффлайн-режиме — около половины производительности Trillium.

По заявлению Google, за счет более крупных блоков умножения матриц и более высокой тактовой частоты Trillium, вероятно, сможет увеличить пиковую производительность в 4,7 раза по сравнению с предыдущим поколением. Ёмкость и пропускная способность HBM-памяти увеличились в 2 раза, также удвоилась пропускная способность между процессорами за счёт использования оптических соединений.

Trillium отличается новым поколением SparceCore, технологии, ускоряющей вложенные «тяжёлые» вычисления по стратегической разгрузке случайного и «точного» доступа к тензорным ядрам. К сожалению, Google пока не представила результаты бенчмарка DLRM ни для одного из поколений своего TPU в подтверждение этому.

Granite Rapids от Intel

Intel снова представила свои процессоры для ИИ-вывода (на этот раз — ни одного предложения от подразделения Habana). Она показала Granite Rapids, серверный процессор Xeon следующего поколения с ядрами полной производительности (P-ядра вместо ядер эффективности, так называемых E-ядер). Granite Rapids в 1,9 раза производительнее процессоров Xeon предыдущего поколения — это усреднённый показатель по всем представленным рабочим нагрузкам, которые включают только младшие модели до GPT-J (6B).

Компания заявила, что в её планах — продолжит инвестировать в ИИ для процессоров, включая внедрение новых типов данных и повышение эффективности набора инструкций AMX.